Google-topman waarschuwt: chatbots kramen soms onzin uit

Een topman van Google waarschuwt dat chatbots met kunstmatige intelligentie (AI) soms 'op overtuigende wijze' onjuiste of misleidende informatie kunnen geven.

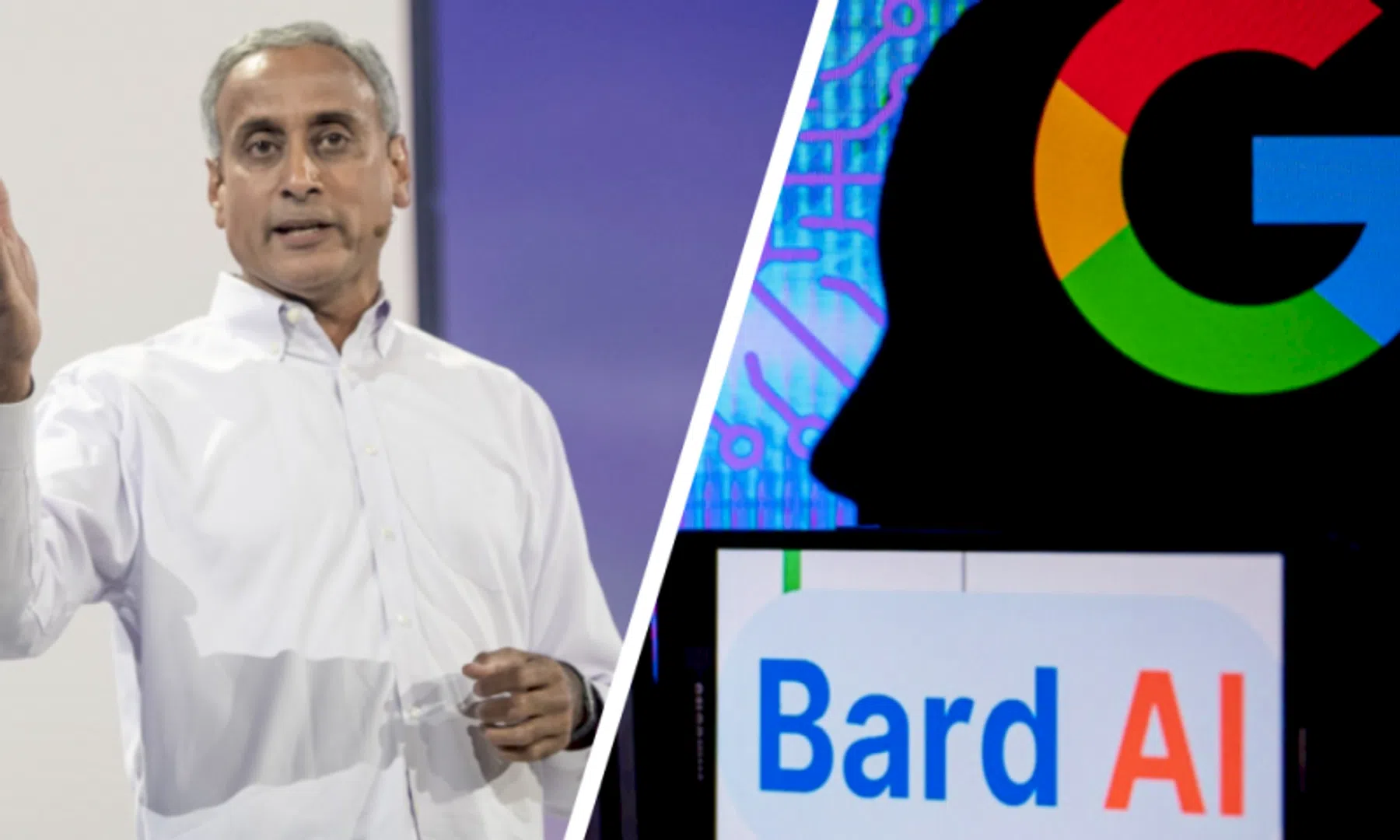

"Het soort kunstmatige intelligentie waar we het nu over hebben, kan soms leiden tot iets dat we 'hallucinatie' noemen: een apparaat geeft een overtuigend maar volledig fictief antwoord”, zegt Google-zoekchef Prabhakar Raghavan in een interview met de Duitse krant Welt Am Sonntag.

Mensen moeten altijd waakzaam zijn met antwoorden die chatbots met behulp van AI geven, zegt de topman. Het is volgens hem dan ook belangrijk dat gebruikers tools krijgen om de informatie te controleren, zoals het vermelden van de bronnen die bij de totstandkoming van een antwoord zijn gebruikt. Raghavan: "We hanteren een zeer hoge standaard. We willen een leider zijn op het gebied van chatbots, wat betreft de integriteit van de informatie en de verantwoordelijkheden die we daarbij nemen. Alleen zo kunnen we het vertrouwen van het publiek behouden."

Valse start voor Google Bard

Vorige week kondigde Google zijn AI-chatbot genaamd Bard aan, dat de concurrentie aangaat met het veelbesproken ChatGPT van OpenAI. Ook kwam Microsoft vorige week met een chatbot in zijn zoekmachine Bing, die een verbeterde versie van OpenAI's taalmodel GPT gebruikt. Microsoft heeft al miljarden in OpenAI geïnvesteerd.

Nadat Bard in een reclamefilmpje van Google zelf een foutief antwoord gaf, ging de beurskoers van het bedrijf onderuit. Beleggers zien de opkomst van chatbots als een gevaar voor de dominantie van de zoekmachine van Google.

Met chatbots krijgen gebruikers direct antwoorden op hun vragen, in plaats van dat ze in zoekresultaten moeten doorklikken naar websites. Voor Google zijn advertenties in de zoekresultaten het belangrijkste verdienmodel. Bard is voorlopig nog alleen door een kleine groep goedgekeurde testers te gebruiken.

Google-personeel boos

Intern leidde de mislukte aankondiging van Bard tot onvrede onder Google-medewerkers, die vonden dat het bedrijf de chatbot te vroeg had aangekondigd. "De Bard-lancering en de ontslagen waren overhaast, mislukt en bijziend", schreef een Google-medewerker volgens CNBC op een intern systeem. De kritiek volgt nadat Google onlangs 12.000 banen heeft geschrapt.

Volgens Raghavan voelde Google de 'urgentie' om Bard nu al te demonstreren. “Maar we voelen ook de grote verantwoordelijkheid. We willen het publiek absoluut niet misleiden", aldus de topman tegen de Duitse krant.

De gigantische taalmodellen achter de chatbots maken het volgens Raghavan 'voor mensen onmogelijk om elk denkbaar gedrag van het systeem te volgen'. "Maar we willen het op een voldoende grote schaal testen, zodat we uiteindelijk tevreden zijn met de statistieken over de controle van de feitelijkheid van de antwoorden."

Vooroordelen en schadelijk gebruik

De snelle populariteit van taalbots als ChatGPT en AI-systemen om afbeeldingen te genereren heeft geleid tot zorgen over de verspreiding van desinformatie en mogelijke schendingen van het auteursrecht. Amerikaanse politici hebben er vorige maand bij OpenAI op aangedrongen om ervoor te zorgen dat de AI-systemen van het bedrijf geen vooroordelen bevatten die zouden kunnen leiden tot discriminatie, zoals rond sollicitaties en huisvesting.

Ook vrezen Amerikaanse wetgevers dat AI-systemen als ChatGPT misbruikt kunnen worden door vijandige groeperingen of staten. "Kwaadwillenden die belangen hebben die tegenstrijdig zijn aan die van de Verenigde Staten kunnen deze systemen gebruiken om informatie te genereren die verkeerd of schadelijk kan zijn", zegt advocaat Andrew Burt tegen Reuters. Hij voert overleg met Amerikaanse wetgevers die aan nieuwe regelgeving rond AI-chatbots werken.

Mira Murati, de chief technology officer van OpenAI, erkent dat overheden en politici bij de ontwikkeling van AI een belangrijke rol hebben. "We hebben veel meer input nodig, ook van regelgevers en regeringen. Het is zeker niet te vroeg voor overheden om zich te mengen in de discussie. Het is erg belangrijk voor iedereen om mee te doen, gezien de impact die deze technologieën zullen hebben."

ChatGPT is te manipuleren

ChatGPT-gebruikers ontdekten onlangs dat het systeem is te manipuleren, waarna de chatbot omstreden meningen en vuige taal gaat uitkramen, en zelfs adviezen over illegale activiteiten gaat geven. Die kwaadaardige 'persona' van ChatGPT staat bekend als DAN, kort voor 'do anything now'.

Deze vorm van misbruik van de chatbot van OpenAI heeft nu ook de aandacht van Microsoft getrokken. Een topman van Microsofts cloudplatform Azure verwees er vorige week naar tijdens een congres over cyberbeveiliging. Gemanipuleerde chatbots zoals DAN zouden volgens hem 'een van de uitdagingen voor cyberbeveiligers in de nabije toekomst' vormen.